Aufs Glatteis geführt

"So souverän die Antworten von ChatGPT auch klingen – das KI-System lässt sich verblüffend leicht verunsichern und zu Falschantworten verleiten. Das haben US-Forscher entdeckt, als sie GPT-3.5 und GPT-4 in die Irre führten, indem sie deren korrekten Antworten für falsch erklärten. Die künstliche Intelligenz änderte ihre Antwort daraufhin oft, obwohl sie Recht hatte. Dies bestätigt erneut, dass diese KI-Systeme ihre Inhalte nicht wirklich verstehen..."

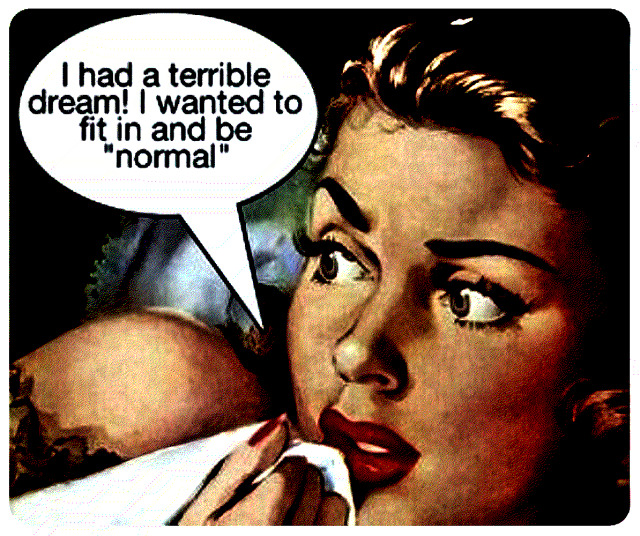

Logisch. KI wird weniger programmiert als vielmehr trainiert, und das führt zu ganz normalem neurotypischem Verhalten. "Inhalte wirklich verstehen" ist ja schon für die durchschnittliche Natürliche Intelligenz arg viel verlangt, besonders im Nonkonformitätsfall.

Bild hier geklaut:

https://rumpletweezer.loforo.com/5hehp